亮点

KAT-Dev-32B 是一个开源的 32B 参数模型,用于软件工程任务。

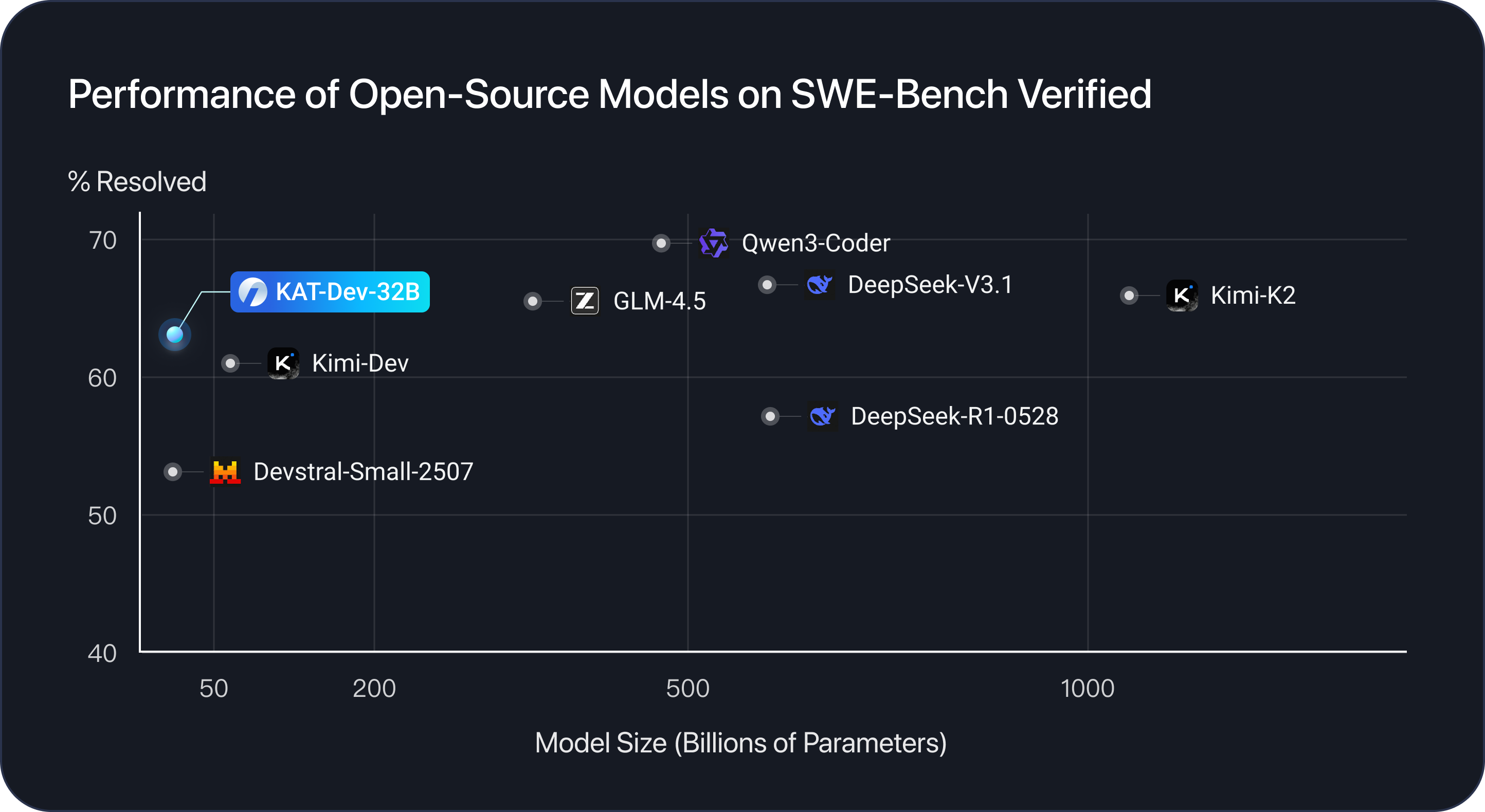

在 SWE-Bench Verified 上,KAT-Dev-32B 达到了 62.4% 的解决率,并在所有不同规模的开源模型中排名 第 5 位。

简介

KAT-Dev-32B 经过多个阶段的训练进行优化,包括中期训练阶段、监督微调(SFT)和强化微调(RFT)阶段以及大规模代理强化学习(RL)阶段。总结起来,我们的贡献包括:

| 阶段 | 关键技术 |

|---|---|

| 1. 中期训练 | 我们观察到,在此阶段增加工具使用能力、多轮交互和指令跟随的广泛训练可能不会在当前结果中带来显著的性能提升(例如,在 SWE-bench 排行榜上)。然而,由于我们的实验基于 Qwen3-32B 模型,我们发现增强这些基础能力将对后续的 SFT 和 RL 阶段产生重大影响。这表明,改进这些核心能力可以深刻影响模型处理更复杂任务的能力。 |

| 2. SFT & RFT | 我们在 SFT 阶段精心策划了八种任务类型和八种编程场景,以确保模型的泛化能力和全面能力。此外,在 RL 之前,我们创新性地引入了 RFT 阶段。与传统的 RL 相比,我们在训练过程中加入了由人类工程师标注的“教师轨迹”作为指导——就像一个新手司机在正式驾驶前由经验丰富的副驾协助一样。这一步不仅提升了模型性能,还进一步稳定了后续的 RL 训练。 |

| 3. 代理 RL 扩展 | 扩展代理 RL 依赖于三个挑战:非线性轨迹历史上的高效学习、利用内在模型信号以及构建可扩展的高吞吐量基础设施。我们通过在 RL 训练引擎中采用多层次前缀缓存机制、基于熵的轨迹修剪技术以及内部实现 SeamlessFlow[1] 架构来解决这些问题,该架构清晰地将代理与训练分离,同时利用异构计算。这些创新共同降低了扩展成本,并实现了高效的大型 RL。 |

有关更多详细信息,包括基准评估、硬件要求和推理性能,请参阅我们的 博客。

快速开始

from modelscope import AutoModelForCausalLM, AutoTokenizer

model_name = "Kwaipilot/KAT-Dev"

# load the tokenizer and the model

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

# prepare the model input

prompt = "Give me a short introduction to large language model."

messages = [

{"role": "user", "content": prompt}

]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True,

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

# conduct text completion

generated_ids = model.generate(

**model_inputs,

max_new_tokens=65536

)

output_ids = generated_ids[0][len(model_inputs.input_ids[0]):].tolist()

content = tokenizer.decode(output_ids, skip_special_tokens=True)

print("content:", content)

Claude Code

vllm 服务器

MODEL_PATH="Kwaipilot/KAT-Dev"

VLLM_USE_MODELSCOPE=true vllm serve $MODEL_PATH \

--enable-prefix-caching \

--tensor-parallel-size 8 \

--tool-parser-plugin $MODEL_PATH/qwen3coder_tool_parser.py \

--chat-template $MODEL_PATH/chat_template.jinja \

--enable-auto-tool-choice --tool-call-parser qwen3_coder

claude-code-router 是一个第三方路由实用程序,允许 Claude Code 灵活地在不同的后端 API 之间切换。

在 dashScope 平台上,您可以安装 claude-code-config 扩展包,它会自动生成带有内置 dashScope 支持的 claude-code-router 默认配置。

一旦生成了配置文件和插件目录,ccr 所需的环境就准备好了。

如果需要,您仍然可以手动编辑 ~/.claude-code-router/config.json 和 ~/.claude-code-router/plugins/ 下的文件来自定义设置。

最后,只需启动 ccr 即可运行 Claude Code,并无缝连接到 KAT-Dev-32B 强大的编码能力。

愉快编码!