前两周,千问团队陆续更新了 Qwen3-235B-A22B 和 Qwen3-30B-A3B 的 Instruct/Thinking 「2507」版本模型,最近发布更小尺寸新模型——Qwen3-4B-Instruct-2507 和 Qwen3-4B-Thinking-2507 。

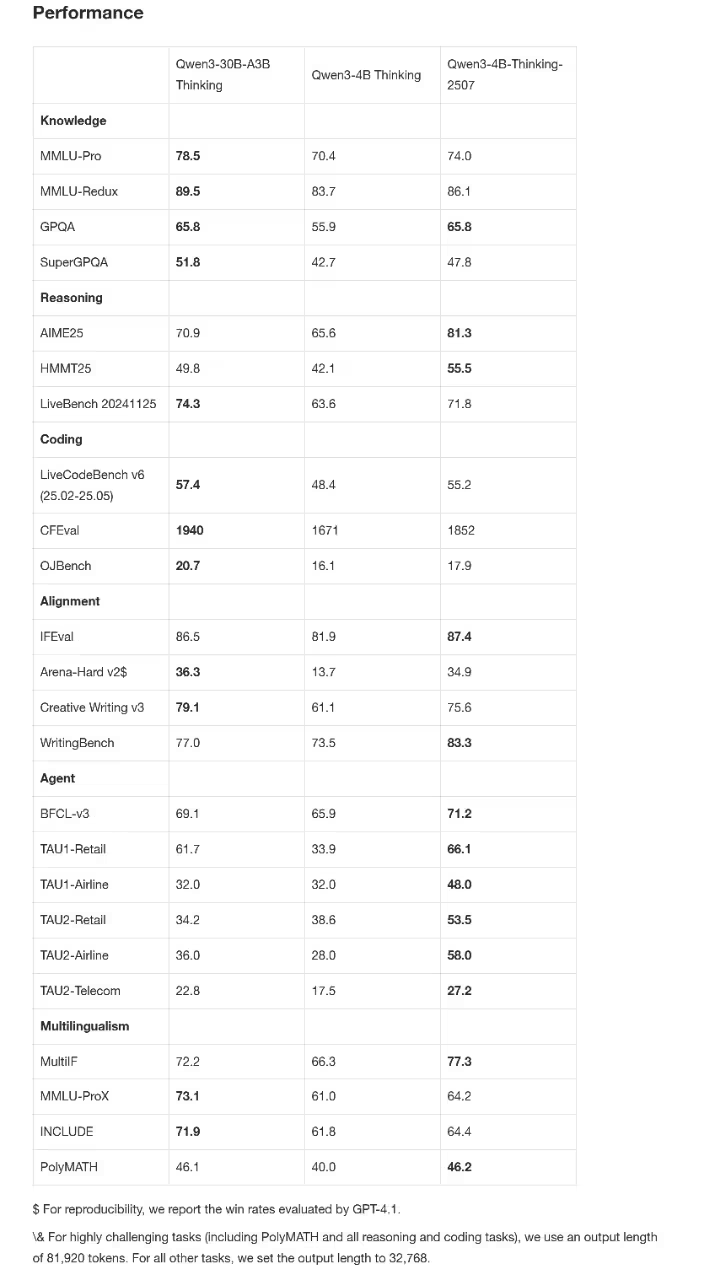

新模型性能大幅提升。在非推理(non-thinking)领域,Qwen3-4B-Instruct-2507 全面超越了闭源的 GPT4.1-Nano;在推理(thinking)领域,Qwen3-4B-Thinking-2507 甚至可以媲美中等规模的 Qwen3-30B-A3B(thinking)。

SLM(Small Language Models)对 Agentic AI 的发展极具价值。「2507」版本的 Qwen3-4B 模型,体积小,性能强,对手机等端侧硬件部署尤为友好。目前新模型已在魔搭社区、Hugging Face正式开源,欢迎大家前往体验👏

以下为模型核心亮点——

1、Qwen3-4B-Instruct-2507

🌟通用能力显著提升,更全能的端侧利器。 新模型通用能力超越了闭源的小尺寸模型 GPT-4.1-nano,与中等规模的 Qwen3-30B-A3B(non-thinking)性能接近。

🌟掌握更多语言和长尾知识,回答更合你意。

🌟上下文理解扩展至 256K,小模型也能处理长文本。

2、 Qwen3-4B-Thinking-2507

🌟推理能力大幅增强,AIME25 高达81.3分。 Qwen3-4B-Thinking-2507 的推理表现可媲美中等模型 Qwen3-30B-Thinking,在聚焦数学能力的 AIME25 测评中,以4B参数量斩获惊人的81.3分的好成绩!

🌟通用能力显著提升,Agent 分数爆表,相关评测均超越了更大尺寸的Qwen3-30B-Thinking模型。

🌟 256K tokens 上下文的理解能力,支持更复杂的文档分析、长篇内容生成、跨段落推理等场景。

原创文章,转载请注明: 转载自诺德美地科技

本文链接地址: Qwen3-4B超顶小模型登场