GGUF(原名 GGML),是一个用于量化和推理大语言模型的格式。提供一种高效的模型存储格式,特别是支持量化模型(如4-bit、5-bit等低精度模型)。被广泛用于本地化部署小到中型的LLM,主要由 llama.cpp 提供后端推理。

MLX(Apple Machine Learning eXtension), 由 Apple 开发:专门为苹果设备(Mac、iPad、iPhone)设计的机器学习框架。在苹果生态中高效运行机器学习模型(包括大语言模型),支持 GPU 加速(Apple Silicon 的 NPU)。

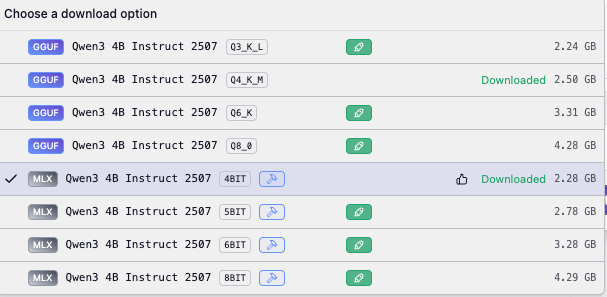

在LM-Studio中,最近发布的Qwen3-4B-2507同时支持了这两种格式,那么来测试下不同格式的性能表现。

GGUF下载Q4_K_M,MLX下载4BIT, 由于每个权重的比特数不同,Q4_K_M (4.7 BPW)与 MLX-4bit (4.5 BPW) 相比,GGUF的尺寸稍大。

对于同一个问题,测试结果:

| 生成总数 | 生成速度 | |

| GGUF | 685 token | 68.02 token/s |

| MLX | 693 token | 99.65 token/s |

可以看到,MLX比GGUF在Apple Silicon处理器上运行快46.5% ,如果你使用的本地大模型提供MLX格式,尽量考虑使用MLX格式。

原创文章,转载请注明: 转载自诺德美地科技